异常检测 Skip-GANomaly 文章快读

Skip-GANomaly: Skip Connected and Adversarially Trained Encoder-Decoder Anomaly Detection

源代码地址:

文章提出了一种新颖的异常检测方法,利用一种跳跃连接的编码器-解码器(卷积神经)结构,并采用对抗生成的方式训练。对抗训练已经在GAN中广泛应用,这种UNet风格中的跳过连接(编码器-解码器)能够多尺度捕获图像空间细节,并有可以从模型学习到的分布中生成高质量的正态图像。本文提出的方法也通过类似GAN生成器-鉴别器的方式,学习图像和潜在空间中的正态分布。鉴别器网络不仅强制生成器学习一个改进的分布模型,而且作为一个特征提取器。

本文的工作:

- 无监督异常检测—一种独特的无监督对抗训练机制,通过一个跳跃连接的编码器-解码器卷积网络结构,在图像和潜在向量空间内产生独特的重建。

- 提出方法的有效性:在数量和质量上优于现有的最先进的方法。

- 方法可复现:本文简单而有效的算法,可以很容易地复制。

相关方法的综述

Schlegl等人的文献[9]是使用对抗性训练进行异常检测最具影响力的描述之一。作者假设GAN的潜向量代表了数据的分布。然而,映射到GAN的向量空间并不简单。为了实现这一点,作者首先使用正常图像训练一个发生器和鉴别器。接下来,他们通过冻结权值来利用预先训练好的生成器和鉴别器,并通过基于z向量的优化GAN重新映射到潜在向量。在推理过程中,模型通过输出高异常分数来确定异常,报告比以前的工作有了显著的改进。这项工作的主要限制是其计算复杂性,因为该模型采用两阶段的方法,并重新映射潜在向量是非常昂贵的。在一项后续研究中,Zenati等人[12]研究了BiGAN[18]在异常检测任务中的使用,研究了同时从图像空间映射到潜在空间,反之亦然的联合训练。在MNIST[19]数据集上,通过[9]对模型进行训练可以得到更好的结果。在一个类似的研究中,对图像和潜在向量空间进行了优化以进行异常检测,Akçay等人[13]提出了一种对抗网络,该网络的生成器由编码器-解码器-编码器子网络组成。该模型的目标不仅是使真实和假正常图像之间的距离最小,而且使它们的潜在向量表示内的距离共同最小化。所提出的方法在统计和计算方面都达到了最先进的性能。

背景知识

GAN

生成式对抗网络(Generative Adversarial Networks, GAN)是一种无监督深度神经结构,通过从最初隐藏的表示中预测特征来学习捕捉任何输入数据分布。GAN的理论最初是在[11]中提出的,它基于零和博弈框架下两个网络之间的竞争,就像最初在博弈论中使用的那样。第一个网络称为生成器(G),它的任务是通过预测隐藏表示(通常是随机噪声向量)的特征(或图像)来捕获给定类标签的输入数据集的分布。因此,生成网络具有解码器网络结构,可以对输入的任意潜在表示进行上采样以生成高维特征。被称为鉴别器(D)的第二个网络的任务是根据给定的特征(或图像)预测正确的类别(即真假)。鉴别器网络通常采用编码器网络结构,对给定的高维特征预测其类标签。通过基于零和博弈框架的优化,各网络增强其预测能力,直至达到均衡状态。

然而,联合训练两个网络以达到平衡,并不是一个简单的过程,因为导致训练不稳定的问题。最近,人们对通过几种实证方法[21],[22]来解决不稳定问题。Radford和Chintala[23]的一项创新和开创性的工作,通过在整个网络中使用完全卷积层和批标准化[24],开创了一种稳定GAN训练的新方法。另一个著名的方法是在训练目标中使用瓦瑟斯坦损失,这也同样显著改善了训练问题[25],[26]。

AAE

对抗自动编码器(Adversarial Auto-Encoders,AAE)在概念上类似于GAN。它同样由一个生成器和一个鉴别器网络组成。该生成器具有领结式架构网络风格,包括一个编码器和一个解码器。生成器的任务是重建输入数据,首先将其降采样为潜在表示,然后将潜在向量上采样为重建数据(图像)。鉴别器网络的任务是预测输入是来自自编码器的潜在向量还是任意初始化的先验分布。

GAN推断

输入噪声向量和生成网络的输出有很强的相关性。相似的潜在空间变量已被证明能产生视觉上相似的高维图像。找到最优潜在向量来创建类似图像的一种方法是通过图像的梯度将图像反向映射回它们的隐藏空间。或者,使用一个额外的编码网络,将高维图像下采样到低维潜在空间,然后GAN能够学习逆向映射。另一种通过逆映射学习推理的方法是联合训练两个网络,前者将图像映射到潜在空间,后者将此潜在空间表示映射回高维图像空间。基于这些研究,本文的主要目的是探索推理GAN,通过利用潜在向量表示来找到一个正态(非异常)数据分布的唯一表示,这样它就可以从统计上区别于看不见的、未知的和变化的异常(异常)数据样本。

本文提出的方法

使用一种无监督的方式对抗性地训练我们提出的卷积网络体系结构,模型只在正常样本上进行训练,在正常样本和异常样本上进行测试。

流程

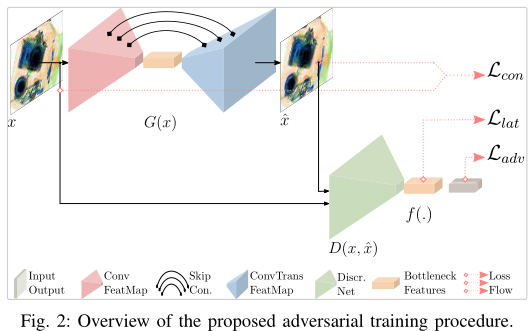

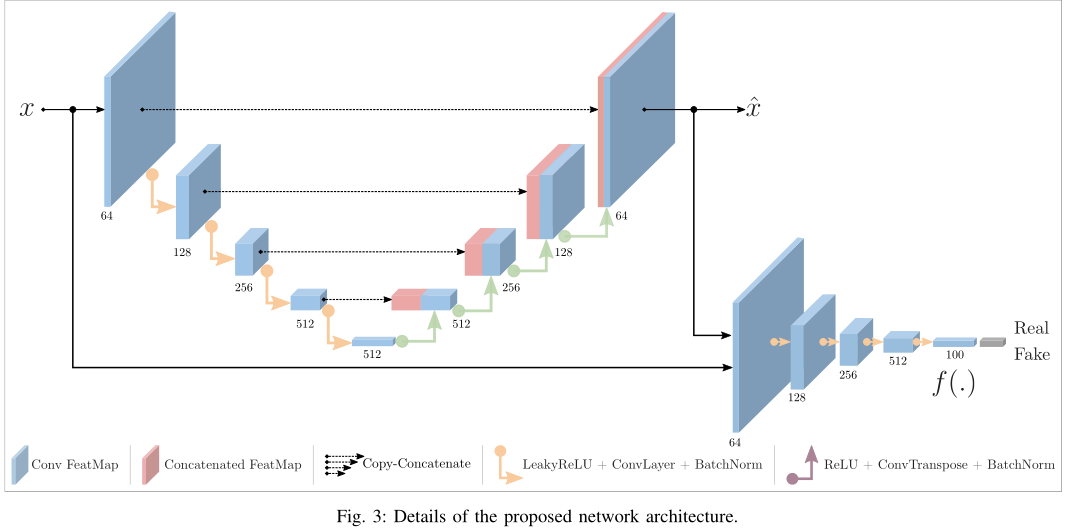

图2是本文方法的流程图,它包含一个生成器G和一个鉴别器D。网络G采用采用编码器(GE)和解码器(GD)网络的领结网络,编码器网络通过将高维图像(x)映射到低维潜在表示(z)来捕获输入数据的分布。如图3所示,编码器网络包含Convolutional层、BatchNorm层和LeakyReLU激活函数的五个块输入。解码器网络采样潜在向量z回到输入图像维数并重构输出。在编码器网络中,每一个下采样层都与相应的上采样解码器层相连(图3)。这种跳跃连接的使用通过层间直接的信息传输提供了巨大的优势,同时保留了局部和全局(多尺度)信息,从而产生更好的重构。我们叫它skip-connection方法。

图3 右下角的是解码器,用作预测给定输入的类标签。它的任务是将真实图像(x)与网络G生成的虚假图像( $\hat x$ )进行分类。鉴别器D的网络结构与[23]中提出的DCGAN方法的鉴别器的结构相同。除了作为一个分类器,网络D还被用作一个特征提取器,以便计算输入图像x和重建图像 $\hat x$的潜在表示。与以前的方法相比,该方法的创新之处在于从鉴别器中提取特征并在潜在空间内进行推理。

训练目标

本文思路是只对正常样本进行模型训练,对正常样本和异常样本同时进行测试。其目的是期望模型能够在图像或潜在向量空间中正确地重构正常样本。其假设是,由于网络从未在异常样本上进行过训练,因此网络无法重构异常样本。因此,对于异常样本,对于输出图像表示ˆx或潜在表示ˆz的重建将会有更高的损失。为了验证这一点,我们建议结合三个损失值(对抗项、上下文项、隐藏项),每个损失值在整体训练目标中都有自己的贡献。

-

对抗项损失:为了最大化训练过程中对正常图像x的重建能力,我们利用了[11]中提出的对抗性损失。这里的任务是让生成网络的目标函数最小,让鉴别网络的目标函数最大。

$$\begin{equation} \mathcal{L}{a d v}=\underset{x \sim p{x}}{\mathbb{E}}[\log D(x)]+\underset{x \sim p_{x}}{\mathbb{E}}[\log (1-D(\hat{x})] \end{equation}$$

-

上下文损失:上面的对抗损失能够让网络产生更加真实的样本,但不能保证能学习到输入的上下文信息。为了明确地学习这个上下文信息,充分捕获正态样本的输入数据分布,我们利用L1正则化。

$$\begin{equation} \mathcal{L}{\text {con }}=\underset{x \sim p{x}}{\mathbb{E}}|x-\hat{x}|_{1} \text { . } \end{equation}$$

-

隐藏损失:上面两项损失能够让网络产生更加真实的样本并且和上下文较为相似。除了这两个目标,我们还希望生成的样本和原样本有相似的潜在表示。因此我们使用鉴别器D的最后一个卷积层来提取x和$\hat{x}$的特征,重构他们的特征,

$$\begin{equation} \mathcal{L}{\text {lat }}=\underset{x \sim p{x}}{\mathbb{E}}|f(x)-f(\hat{x})|_{2} \text { . } \end{equation}$$

最后,总的损失是上面三项的加权和。

$$\begin{equation} \mathcal{L}=\lambda_{a d v} \mathcal{L}_{a d v}+\lambda_{c o n} \mathcal{L}_{c o n}+\lambda_{l a t} \mathcal{L}_{l a t} \end{equation}$$

为了在测试中发现异常,我们采用了[9][12]中提出的异常评分,对于每个测试图像,评分为

$$\begin{equation}\mathcal{A}(\dot{x})=\lambda R(\dot{x})+(1-\lambda) L(\dot{x})\end{equation}$$

公式的第一项和第二项分别表示了公式2上下文评分和公式3潜在表示得分。利用公式5求出每个测试样本的评分,构成向量$A$,按照[13]中提出的步骤,对A进行特征缩放,将异常分数缩放到[0,1]的概率范围内。变换后的评分为

$$\begin{equation}\hat{\mathcal{A}}(\dot{x})=\frac{\mathcal{A}(\dot{x})-\min (\boldsymbol{A})}{\max (\boldsymbol{A})-\min (\boldsymbol{A})}\end{equation}$$

实验部分

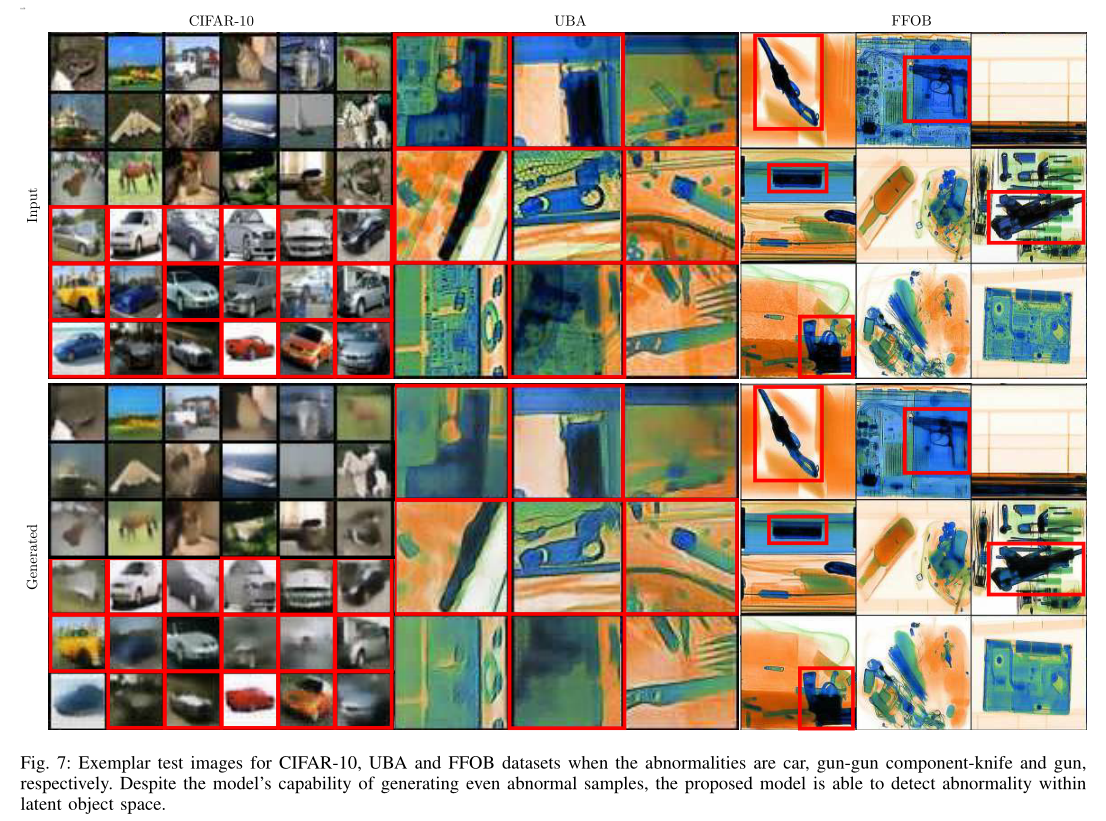

文章采用了CIFAR-10、UBA和FFOB数据集进行验证。利用CIFAR-10测试保留某一类的异常检测问题。产生10个不同的异常案例,每个案例采用45000个正常的训练样本和正常异常数量比值为9000:6000的测试样本。

UBA是大学生行李数据集,它包括230275张双能量x射线安全图像包,通过64 × 64重叠滑动窗口方法提取。数据集包含3个异常子类:knife(63,496)、gun(45,855)和gun component(13,452)。正常类由107,472个良性x射线Patches组成,通过80:20的训练测试比进行划分。

FFOB是完整枪支vs良性操作数据集。它包括专业隐藏的枪支(威胁)物品和商业x光安检操作(行李/包裹)的良性(无威胁)图像。该数据集记为FFOB,由4680张作为完全异常的火器全武器图像和67672张正常的良性操作图像组成。

公式4采用的优化器是Adam。模型的性能评价参数有ROC曲线的AUC、真阳性率TPR和假阳性率FPR。ROC曲线的横坐标是FPR,纵坐标是TPR,AUC是ROC下方的面积,它越接近于1说明分类效果越好。

总结

本文的特点是利用对抗网络来解决无监督异常检测问题,在生成器中加入了跳跃连接,并且损失函数使用三项加权,生成特征、从鉴别器中提取特征、和L1范数正则化三项加权后都加入到损失函数中。跳跃连接提供了更稳定的训练,并且从鉴别器获得的推理学习在数值上优于现有的最先进的方法。

参考文献

[1] M. Markou and S. Singh, “Novelty detection: a review—part 1:

statistical approaches,” Signal Processing, vol. 83, no. 12, pp. 2481–

2497, dec 2003. [Online]. Available: https://www.sciencedirect.com/

science/article/pii/S0165168403002020 I, II

[2] ——, “Novelty detection: a review—part 2:: neural network based

approaches,” Signal Processing, vol. 83, no. 12, pp. 2499–2521,

dec 2003. [Online]. Available: https://www.sciencedirect.com/science/

article/pii/S0165168403002032 I, II

[3] V . Hodge and J. Austin, “A Survey of Outlier Detection

Methodologies,” Artificial Intelligence Review, vol. 22, no. 2, pp. 85–

126, oct 2004. [Online]. Available: http://link.springer.com/10.1023/B:

AIRE.0000045502.10941.a9 I, II

[4] V . Chandola, A. Banerjee, and V . Kumar, “Anomaly detection,” ACM

Computing Surveys, vol. 41, no. 3, pp. 1–58, jul 2009. I, II

[5] M. A. Pimentel, D. A. Clifton, L. Clifton, and L. Tarassenko, “A review

of novelty detection,” Signal Processing, vol. 99, pp. 215–249, 2014. I,

II

[6] A. Abdallah, M. A. Maarof, and A. Zainal, “Fraud detection system: A

survey,” Journal of Network and Computer Applications, vol. 68, pp.

90–113, jun 2016. [Online]. Available: https://www.sciencedirect.com/

science/article/pii/S1084804516300571 I

[7] M. Ahmed, A. Naser Mahmood, and J. Hu, “A survey of network

anomaly detection techniques,” Journal of Network and Computer

Applications, vol. 60, pp. 19–31, jan 2016. [Online]. Available: https:

//www.sciencedirect.com/science/article/pii/S1084804515002891 I

[8] M. Ahmed, A. N. Mahmood, and M. R. Islam, “A survey of anomaly

detection techniques in financial domain,” Future Generation Computer

Systems, vol. 55, pp. 278–288, feb 2016. [Online]. Available: https:

//www.sciencedirect.com/science/article/pii/S0167739X15000023 I

[9] T. Schlegl, P . Seeböck, S. M. Waldstein, U. Schmidt-Erfurth, and

G. Langs, “Unsupervised anomaly detection with generative adversarial

networks to guide marker discovery,” Lecture Notes in Computer Science

(including subseries Lecture Notes in Artificial Intelligence and Lecture

Notes in Bioinformatics), vol. 10265 LNCS, pp. 146–147, 2017. I, II,

III-B2, III-D, IV-C, ??, ??

[10] B. R. Kiran, D. M. Thomas, and R. Parakkal, “An overview of deep

learning based methods for unsupervised and semi-supervised anomaly

detection in videos,” Journal of Imaging, vol. 4, no. 2, p. 36, 2018. I,

II

[11] I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley,

S. Ozair, A. Courville, and Y . Bengio, “Generative adversarial nets,” in

Advances in neural information processing systems, 2014, pp. 2672–

2680. I, III-A1, III-C1

[12] H. Zenati, C. S. Foo, B. Lecouat, G. Manek, and V . R. Chan-

drasekhar, “Efficient gan-based anomaly detection,” arXiv preprint

arXiv:1802.06222, 2018. I, II, III-B2, III-D, IV-C, ??, ??

[13] S. Akcay, A. Atapour-Abarghouei, and T. P . Breckon, “Ganomaly: Semi-

supervised anomaly detection via adversarial training,” arXiv preprint

arXiv:1805.06725, 2018. I, II, III-B2, III-D, IV-A, IV-A3, IV-C, ??, ??

[14] M. Sabokrou, M. Khalooei, M. Fathy, and E. Adeli, “Adversarially

learned one-class classifier for novelty detection,” in Proceedings of the

IEEE Conference on Computer Vision and Pattern Recognition, 2018,

pp. 3379–3388. I, II

[15] O. Ronneberger, P . Fischer, and T. Brox, “U-net: Convolutional networks

for biomedical image segmentation,” in International Conference on

Medical image computing and computer-assisted intervention. Springer,

2015, pp. 234–241. I, III-B2

[16] A. Krizhevsky, V . Nair, and G. Hinton, “The cifar-10 dataset,” online:

http://www. cs. toronto. edu/kriz/cifar . html, 2014. I, IV-A

[17] “OSCT Borders X-ray Image Library, UK Home Office Centre for

Applied Science and Technology (CAST),” Publication Number: 146/16,

2016. I, IV-A3

[18] J. Donahue, P . Krähenbühl, and T. Darrell, “Adversarial Feature

Learning,” in International Conference on Learning Representations

(ICLR), Toulon, France, apr 2017. [Online]. Available: http://arxiv.org/

abs/1605.09782 II, III-A3

[19] Y . LeCun and C. Cortes, “MNIST handwritten digit database,” 2010.

[Online]. Available: http://yann.lecun.com/exdb/mnist/ II

[20] A. Creswell, T. White, V . Dumoulin, K. Arulkumaran, B. Sengupta, and

A. A. Bharath, “Generative adversarial networks: An overview,” IEEE

Signal Processing Magazine, vol. 35, no. 1, pp. 53–65, 2018. III-A1,

III-A2

[21] T. Salimans, I. Goodfellow, W. Zaremba, V . Cheung, A. Radford, and

X. Chen, “Improved techniques for training gans,” in Advances in Neural

Information Processing Systems, 2016, pp. 2234–2242. III-A1

[22] M. Arjovsky and L. Bottou, “Towards Principled Methods for Training

Generative Adversarial Networks,” in 2017 ICLR, April 2017. [Online].

Available: http://arxiv.org/abs/1701.04862 III-A1

[23] A. Radford, L. Metz, and S. Chintala, “Unsupervised Representation

Learning with Deep Convolutional Generative Adversarial Networks,”

in ICLR, 2016. III-A1, III-A3, III-B2

[24] S. Ioffe and C. Szegedy, “Batch normalization: Accelerating deep

network training by reducing internal covariate shift,” in Proceedings

of the 32nd International Conference on Machine Learning, Lille,

France, 07–09 Jul 2015, pp. 448–456. [Online]. Available: http:

//proceedings.mlr.press/v37/ioffe15.html III-A1

[25] M. Arjovsky, S. Chintala, and L. Bottou, “Wasserstein generative

adversarial networks,” in Proceedings of the 34th International

Conference on Machine Learning, Sydney, Australia, 06–11 Aug

2017, pp. 214–223. [Online]. Available: http://proceedings.mlr.press/

v70/arjovsky17a.html III-A1

[26] I. Gulrajani, F. Ahmed, M. Arjovsky, V . Dumoulin, and A. C. Courville,

“Improved training of wasserstein gans,” in Advances in Neural Infor-

mation Processing Systems, 2017, pp. 5767–5777. III-A1

[27] M. Mirza and S. Osindero, “Conditional generative adversarial nets,”

arXiv preprint arXiv:1411.1784, 2014. III-A2

[28] A. Makhzani, J. Shlens, N. Jaitly, I. Goodfellow, and B. Frey, “Adver-

sarial autoencoders,” in ICLR, 2016. III-A2

[29] X. Chen, X. Chen, Y . Duan, R. Houthooft, J. Schulman, I. Sutskever,

and P . Abbeel, “InfoGAN: Interpretable Representation Learning by

Information Maximizing Generative Adversarial Nets,” in Advances in

Neural Information Processing Systems, 2016, pp. 2172–2180. III-A3

[30] A. Creswell and A. A. Bharath, “Inverting the generator of a generative

adversarial network (ii),” arXiv preprint arXiv:1802.05701, 2018. III-A3

[31] Z. C. Lipton and S. Tripathi, “Precise recovery of latent vectors from

generative adversarial networks,” in ICLR Workshop, 2017. III-A3

[32] V . Dumoulin, I. Belghazi, B. Poole, O. Mastropietro, A. Lamb, M. Ar-

jovsky, and A. Courville, “Adversarially learned inference,” in ICLR,

2017. III-A3

[33] S. Akcay, M. E. Kundegorski, C. G. Willcocks, and T. P . Breckon,

“Using deep convolutional neural network architectures for object clas-

sification and detection within x-ray baggage security imagery,” IEEE

Transactions on Information F orensics and Security, vol. 13, no. 9, pp.

2203–2215, Sept 2018. IV-A

[34] D. Kinga and J. B. Adam, “Adam: A method for stochastic optimiza-

tion,” in International Conference on Learning Representations (ICLR),

vol. 5, 2015. IV-B

[35] A. Paszke, S. Gross, S. Chintala, G. Chanan, E. Yang, Z. DeVito, Z. Lin,

A. Desmaison, L. Antiga, and A. Lerer, “Automatic differentiation in

PyTorch,” 2017. IV-B

[36] C. X. Ling, J. Huang, H. Zhang et al., “Auc: a statistically consistent

and more discriminating measure than accuracy,” in IJCAI, vol. 3, 2003,

pp. 519–524. IV-C